31 ottobre 2018 di Marco Cavani, Sales Manager Area Business - Retelit

Data Center, le bellissime scatole da riempire

I Data Center non sono altro che ambienti specificamente protetti che contengono elementi hardware (tipicamente server); al loro interno vengono conservate, organizzate e veicolate grandissime quantità di informazioni.

News & Eventi

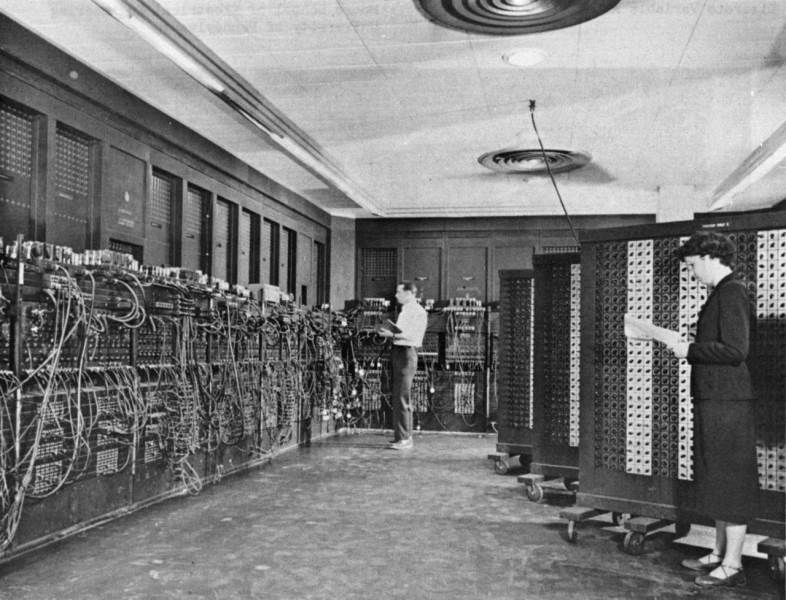

Il concetto di accumulare in un unico luogo grandi quantità di dati ha ormai molti anni. Il Data Center, esattamente con questa accezione, è nato intorno al 1940 e fu di fatto il primo computer elettronico "general purpose" a lanciare la moda, si chiamava ENIAC (Electronic Numerical Integrator and Computer).

Questa modalità di conservare i dati richiedeva una grande quantità di spazio, di energia e di cavi.

Da allora le cose sono cambiate molto velocemente, come ormai la tecnologia ci ha abituato a prevedere, ed in maniera decisamente sostanziale. Oggi i Data Centers hanno mantenuto la medesima funzione, sostanzialmente, ovvero quella di conservare grandi quantità di dati. Si sono arricchiti, però, di molte altre caratteristiche, la più significativa è quella di rendere disponibili questi dati in tempo reale a chiunque si decida ne possa fruire.

Su queste funzionalità si basa sostanzialmente la rete su cui oggi è imperniato tutto ciò che accade nel mondo digitale: navigazione, fruizione delle app, posta elettronica, acquisti, messaggistica istantanea, 5G, streaming TV, ecc... Essendo i Data Centers il fulcro di "tutto quanto", nel tempo hanno richiesto architetture e infrastrutture banalmente sempre migliori. Il boom che ha reso necessario premere sull'acceleratore, dal punto di vista dello sviluppo, si è verificato all'incirca nella seconda metà degli anni '90, momento storico in cui grandi e piccole aziende, soprattutto del settore ICT/TLC, hanno ben compreso la potenzialità (e la profittabilità!) di usare una rete di interconnessioni e di server performanti e affidabili.

Se pensiamo al concetto di Cloud, in effetti, ci riferiamo, né più né meno, a una rete di Data Center distribuita su tutto il pianeta ed interlacciata a grandi dorsali in fibra ottica, via via sempre più granulate e fitte, che li collegano fra loro, collegandoli ovviamente anche a chi li "lavora", nonché a chi ne fruisce i servizi. Ciascuna azienda che fornisce servizi digitali oggi ha a che fare con questo tipo di architetture (Google, Amazon, Microsoft, ecc.…). Tanto più si riesce ad investire sulla qualità di questi "ferri del mestiere" tanto più si acquisisce credibilità sul mercato e si riesce a essere rapidi ed efficaci nella proposizione dei servizi.

Ma come si fa a capire quanto è affidabile e performante un Data Center?

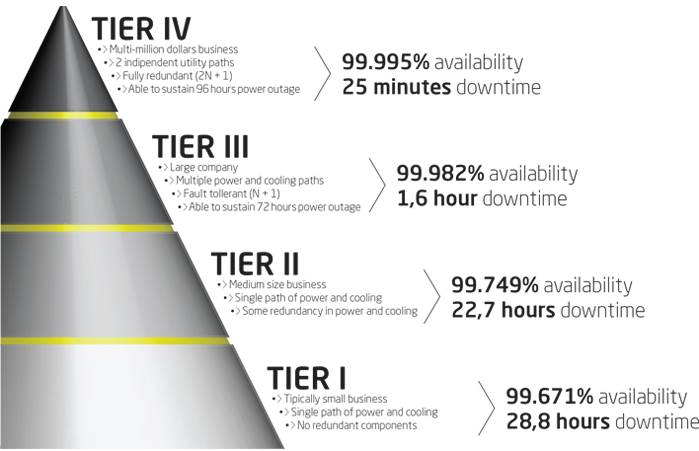

Una delle risposte migliori arriva, come spesso accade, dagli USA, che in questo settore sono stati e sono ancora uno dei motori trainanti a livello planetario. L'Uptime Institute è un ente statunitense il cui scopo è quello di fornire certificazioni che aiutano a classificare i data center sulla base di una serie di principi che tengono conto delle caratteristiche di cui sopra. Tali principi hanno a che fare con l'architettura, il design, la praticità implementativa (in termini di operations specificamente), la modulabilità della struttura e ovviamente l'uptime, cioè per quante ore viene garantito il mantenimento in funzione del servizio Data Center nell’anno (oppure per quante ore è tollerato un fault). La classificazione si basa sul principio di "Tier" ("livello" o "categoria") e va da 1 a 4, dove 4 è il più performante.

Semplificando molto, con l'immagine qui sotto è possibile farsi un'idea su come oggi i data center nel mondo possono essere classificati:

Anche se ad oggi non esiste un vero e proprio standard internazionale univocamente definito, questi criteri sono in grado di delineare una serie di distinzioni piuttosto ben riscontrabili tra un DC e un altro.

Per parlare del bel paese possiamo dire che in Italia abbiamo ormai più di 60 Data Center; tra questi una ventina risiedono in Milano e provincia. In tutto il mondo se ne contano invece ben più di 4.000.

Procedendo nel discorso possiamo aggiungere che le nature dei Data Center possono essere grossolanamente suddivise in due macro categorie:

• quelli costruiti da chi propone servizi terzi e quindi non esclusivamente colocation, hosting e affini (operatori telefonici o di servizi IT in generale)

• quelli costruiti da chi fa solo Data Center

Ad oggi il Tier 4 (cioè il livello qualitativamente più alto) sta diventando sempre più un must, soprattutto per servizi di tipo mission critical. I costi di adeguamento infrastrutturale per portare un Data Center a Tier 4, laddove fosse invece di classificazione inferiore, sono davvero ingenti. Per questo motivo sono oramai in tanti a scegliere partnership con chi realizza Data Center di alto profilo unicamente come mission aziendale o quasi (ad esempio, Data 4, Supernap, Equinix, Aruba, ecc...) invece che investire in aggiornamenti. Proprio in questa ottica, però, diventa allora nodale avere la garanzia di poter raggiungere tali infrastrutture con una connettività che allinei il servizio broadband all'affidabilità del DC che deve servire, in modo da mantenere paritetico il livello della "scatola" a quello del "tubo".

In tal senso Retelit (ed è una citazione assolutamente di parte!) ha scelto quest'ultima via, realizzando per esempio un ring in fibra ottica che collega le strutture di cui sopra e una serie di altri Data Center tra Roma e Milano, creando un ecosistema virtuoso e ridondato che consente di poter accogliere bande fino a 100 Gbps per singolo utente.